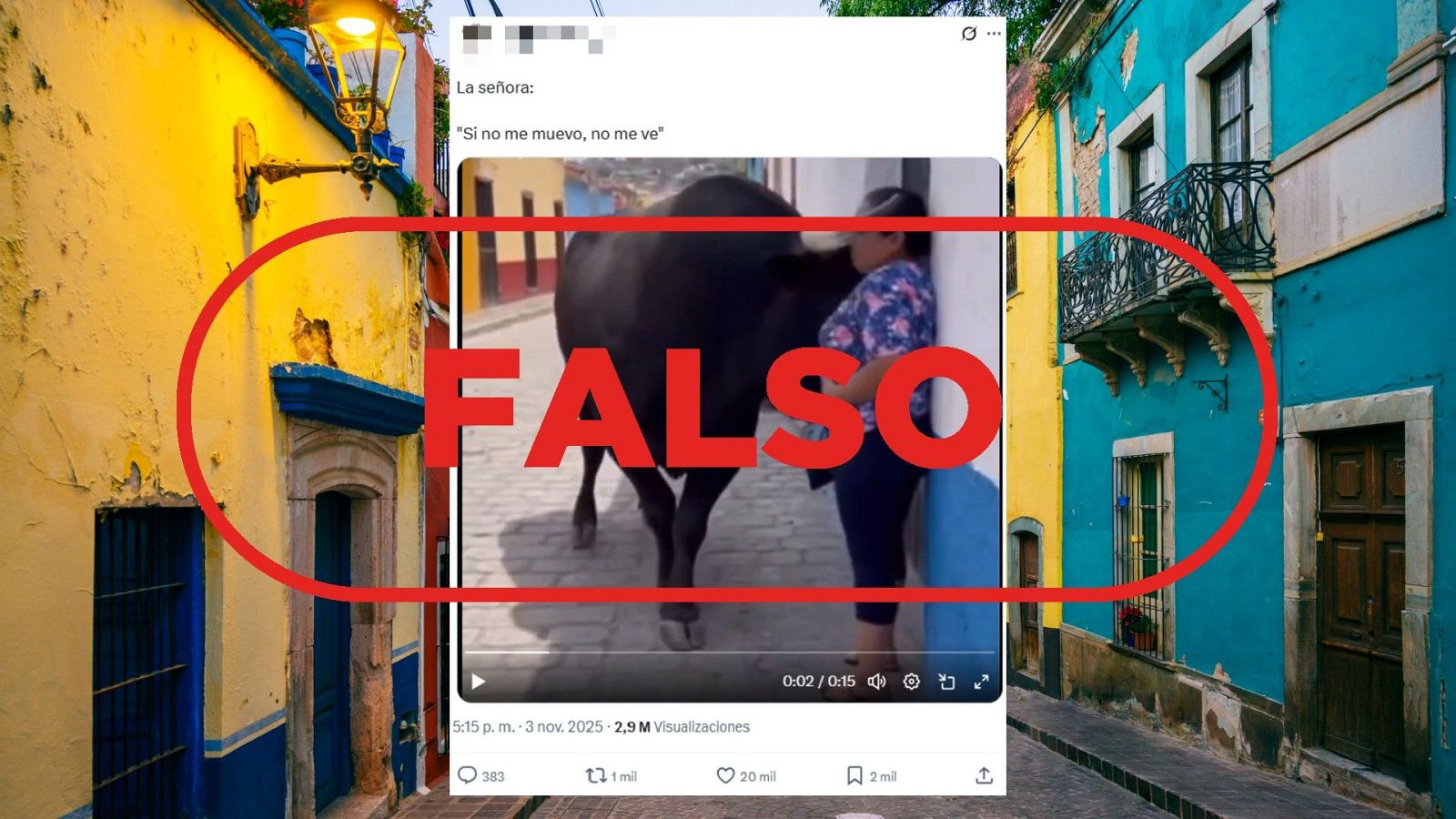

Circula por redes sociales un vídeo de 15 segundos en el que un toro que pasea por una calle se acerca a una señora hasta acorralarla contra la pared y acerca las astas a su cara. El vídeo ha sido compartido miles de veces en X y suma más de 37.000 reproducciones en Facebook en publicaciones que lo presentan como si fuera real. Es falso, se trata de un vídeo generado con inteligencia artificial (IA). Ante el desarrollo de nuevas herramientas generativas que crean contenidos hiperrealistas como este, en VerificaRTVE te ofrecemos cinco consejos para ayudarte a detectar si imágenes como estas están generadas con IA.

1. Localiza el origen de la publicación

Busca si aparece algún elemento que etiquete la imagen como generada por inteligencia artificial o si hace alguna referencia a una aplicación de IA (Grok, Sora, Midjourney, Gemini o Dall-E). Fíjate en el perfil que lo difunde, la fecha de publicación o si aparece otra fuente original donde ampliar la información. Lee los comentarios a esa publicación porque a veces otros usuarios cuestionan la autenticidad del vídeo u ofrecen información adicional que da contexto. Analiza el perfil del creador en diferentes redes sociales. En ocasiones estos contenidos los publican usuarios especializados en creaciones digitales o incluso los vemos en cuentas parodia que podrían indicar que se trata de una grabación generada con IA.

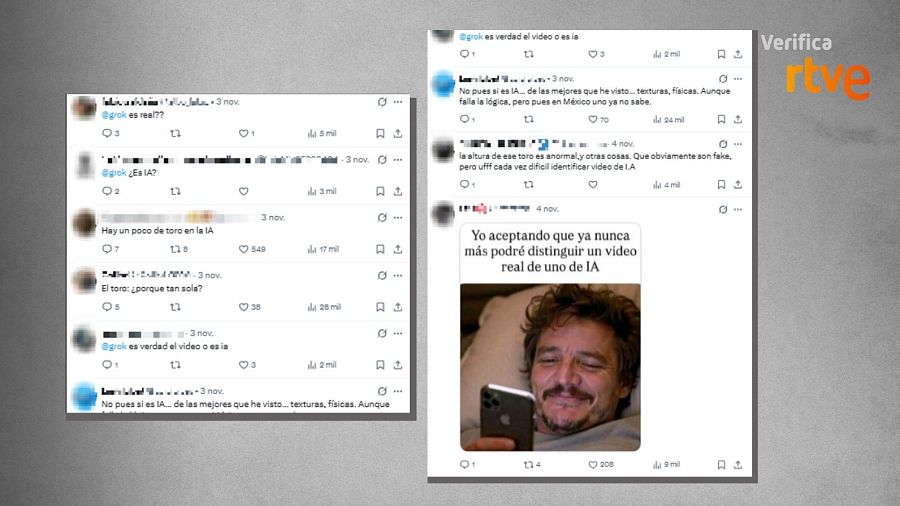

Con una búsqueda inversa de imagen, hemos comprobado que el vídeo del toro suelto en una calle lo compartió por primera vez un perfil de Facebook el 31 de octubre. En su descripción, solo indican que difunden "información sobre México" y en el mensaje no aclaran si está generado con inteligencia artificial ni existen etiquetas que indiquen si se ha utilizado alguna herramienta. No obstante, este paso nos ayudó a desmontar este vídeo falso sobre la guerra de Sudán. En cuanto a la grabación del toro, en los comentarios varios usuarios niegan que el vídeo sea real y, al analizar el perfil que lo difunde, comprobamos que suele compartir vídeos generados artificialmente.

Comentarios a la publicación de usuarios que dudan sobre la autenticidad del vídeo VerificaRTVE

2. Amplían la información con fuentes externas

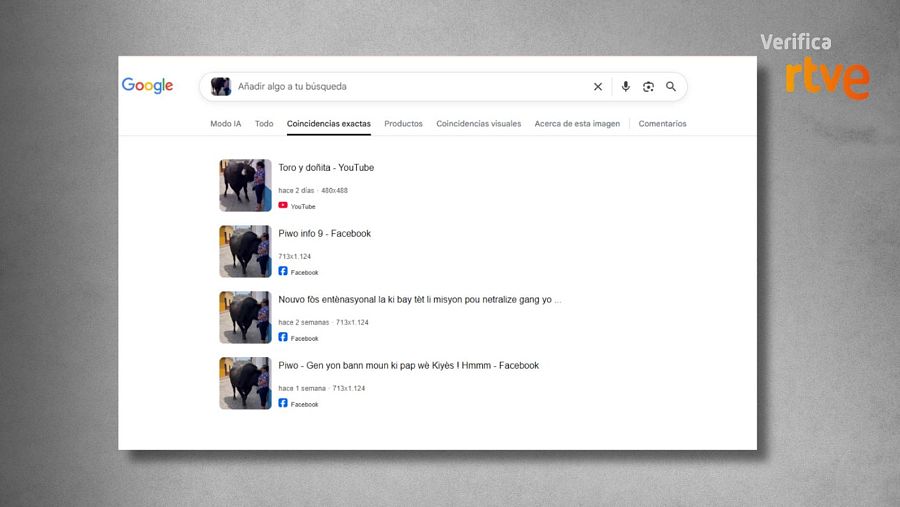

Busca en internet si hay registros de los hechos que muestra el vídeo y contrasta en fuentes oficiales o en medios de comunicación si realmente ocurrió lo que indican las imágenes que aparecen en redes sociales. En este paso, también es útil hacer una captura del vídeo y realizar una búsqueda inversa en alguna herramienta como Google o TinEye.

Resultado de una búsqueda inversa en Google sobre este vídeo VerificaRTVE

En el caso concreto del vídeo del toro, realizamos una búsqueda por palabras clave con los términos "toro", "suelto" o "ciudad". También se puede consultar en los medios de comunicación o en los perfiles de los organismos oficiales del país donde presuntamente suceden los hechos; en este caso, México. En las búsquedas avanzadas en Google se puede ajustar la fecha de los resultados para tener más precisión. Sin embargo, no encontramos ningún resultado en medios sobre un toro que se haya escapado o que haya atacado a alguien recientemente a una persona en este país. En cuanto a la búsqueda inversa de la imagen, los pocos resultados que ofrece remiten al propio vídeo difundido en redes, pero no a ninguna noticia ni a ninguna fuente oficial.

3. Analiza el vídeo y el audio con detenimiento

Observa el vídeo a cámara lenta para detectar incongruencias visuales, revisa si hay sombras, deformaciones, movimiento de manos, pelo o labios y sincronización labial. Escucha el audio: los sonidos generados por inteligencia artificial suelen ser demasiado perfectos o poco naturales.

Al observar el vídeo del toro con detenimiento, encontramos que la sincronización labial de la mujer con el audio presenta fallos. Una voz de alguien que no aparece en el vídeo le advierte de que no se mueva y ella aparentemente responde: "No me muevo". Sin embargo, prácticamente no hay movimiento en sus labios, lo que apunta a un descuadre en la sincronización con el audio. Tampoco se aprecian cambios de tono en su voz a pesar de que mueve la cara y de que su boca no está en dirección a la cámara. Además, el sonido de los pasos y de la respiración del toro es demasiado perfecto y no sube ni disminuye el volumen cuando el toro se acerca a la mujer.

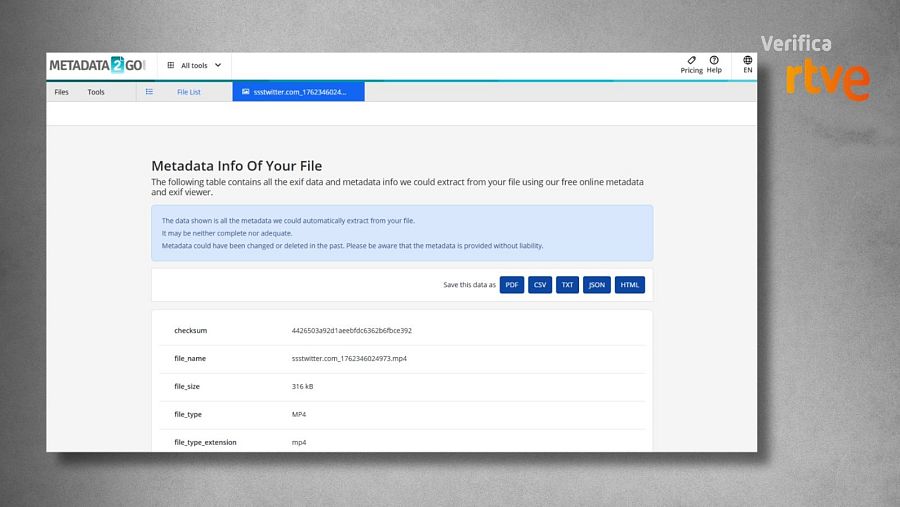

4. Comprueba los metadatos

Los metadatos contienen información sobre fechas, ubicaciones, dispositivos y software de creación. Utiliza herramientas para extraerlos y detecta si hay inconsistencias. Eso sí, para que los metadatos aporten la información real del archivo, tiene que tratarse del original, porque al descargarlo de redes sociales o de WhatsApp los metadatos desaparecen.

Resultado de la herramienta Metadata2Go sobre el vídeo de un toro generado por IA. VerificaRTVE

En el vídeo del toro, introducimos el archivo en la web MetaData2Go y descargamos los metadatos en el formato que prefiramos. Si no sabes cómo leer estos metadatos, también puedes introducirlos en un ‘chatbot’ como Gemini o ChatGPT para preguntarle si son normales o tienen evidencias de estar manipulados. Recuerda que algunas IA pueden eliminar o modificar los metadatos, lo que también indica manipulación.

5. Utiliza los detectores de contenidos generados con IA

Hay multitud de herramientas que se dedican a analizar si los vídeos, las fotos o los audios han sido creados o manipulados con inteligencia artificial (IA). En muchos casos se trata de otras herramientas de IA que están preparadas para detectar si los contenidos han sido creados mediante esta misma tecnología.

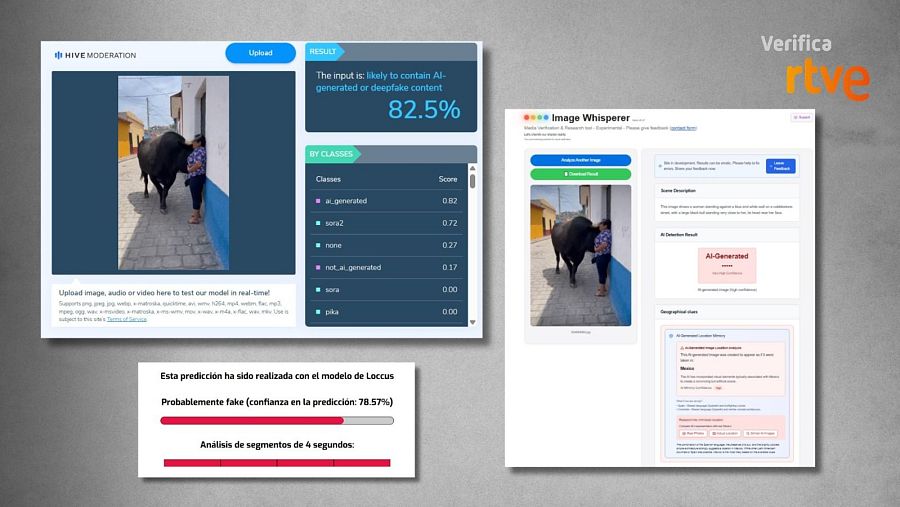

Herramientas de verificación que detectan una alta probabilidad de que el vídeo esté generado con IA VerificaRTVE

Hemos introducido una captura, en la cual el toro acorrala a la mujer, en la herramienta Hive Moderation y detecta, con más de un 82% de probabilidad, que este contenido es falso. La herramienta de verificación Image Whisperer también apunta que se trata de un vídeo hecho con IA y ubica su origen en México. Otro detector de contenidos generados artificialmente, AI or Not, ha comprobado mediante su herramienta de acceso restringido que "probablemente el vídeo ha sido generado con IA", según un mensaje que han publicado en su cuenta de X. La herramienta del proyecto IVERES de RTVE también concluye que el audio no es real, con más de un 78% de fiabilidad en la predicción.

La investigación forense de IA no siempre permite una certeza absoluta. Si no puedes demostrar que un contenido es real, es recomendable prestar atención a las incongruencias que puedan aparecer en las imágenes: fallos en las manos, en las caras o en cualquier elemento gráfico. Por ejemplo, en VerificaRTVE te alertamos de que estas imágenes de la Flotilla que se dirigía a Gaza con ayuda humanitaria estaban generadas artificialmente porque detectamos fallos en las letras del barco o en las banderas palestinas. Y, como ya te explicamos anteriormente, la mejor herramienta es el sentido común: detente, analiza y contrasta.